L’uso dell’intelligenza artificiale nei luoghi di lavoro sta crescendo a ritmo sostenuto. Professionisti delle risorse umane, team finanziari e dirigenti aziendali si affidano sempre più spesso all’AI per velocizzare i processi e prendere decisioni più consapevoli.

Con la diffusione dell’AI nelle attività quotidiane arrivano anche le prime regolamentazioni. L’Atto Europeo sull’Intelligenza Artificiale (EU AI Act), approvato nel 2024, rappresenta il primo regolamento AI Act europeo volto a garantire trasparenza e sicurezza. La sua entrata in vigore è prevista in più fasi tra il 2025 e il 2027, quando sarà pienamente applicabile in tutti gli Stati membri dell’Unione Europea (UE).

Questo nuovo regolamento AI Act UE ha l’obiettivo di promuovere un utilizzo sicuro dell’intelligenza artificiale e ridurre al minimo i rischi per utenti e organizzazioni, in linea con i principi del GDPR.

In questa guida vedremo cos’è l’AI Act, cosa prevede il suo testo ufficiale, e quali implicazioni comporta per le aziende europee, italiane e internazionali. Comprendere fin da subito le disposizioni dell’EU AI Act consente di evitare sanzioni, ridurre i rischi di non conformità e favorire una cultura aziendale basata su trasparenza, etica e responsabilità.

- I punti chiave della normativa

- L’integrazione dell’EU AI Act nel quadro normativo italiano

- Cos’è l’EU AI Act

- Sintesi dell’EU AI Act

- Impatto della regolamentazione AI per i datori di lavoro

- Come l’AI di Factorial supporta la conformità

- Domande sull’EU AI Act

Il potere nascosto dell’AI: cosa le aziende devono sapere

Scopri oltre 100 suggerimenti pratici e le lezioni di 1.500 leader globali per sfruttare l’AI.

Scaricare gratis

I punti chiave della normativa

- L’AI Act dell’Unione Europea è la prima normativa completa adottata per regolamentare l’intelligenza artificiale.

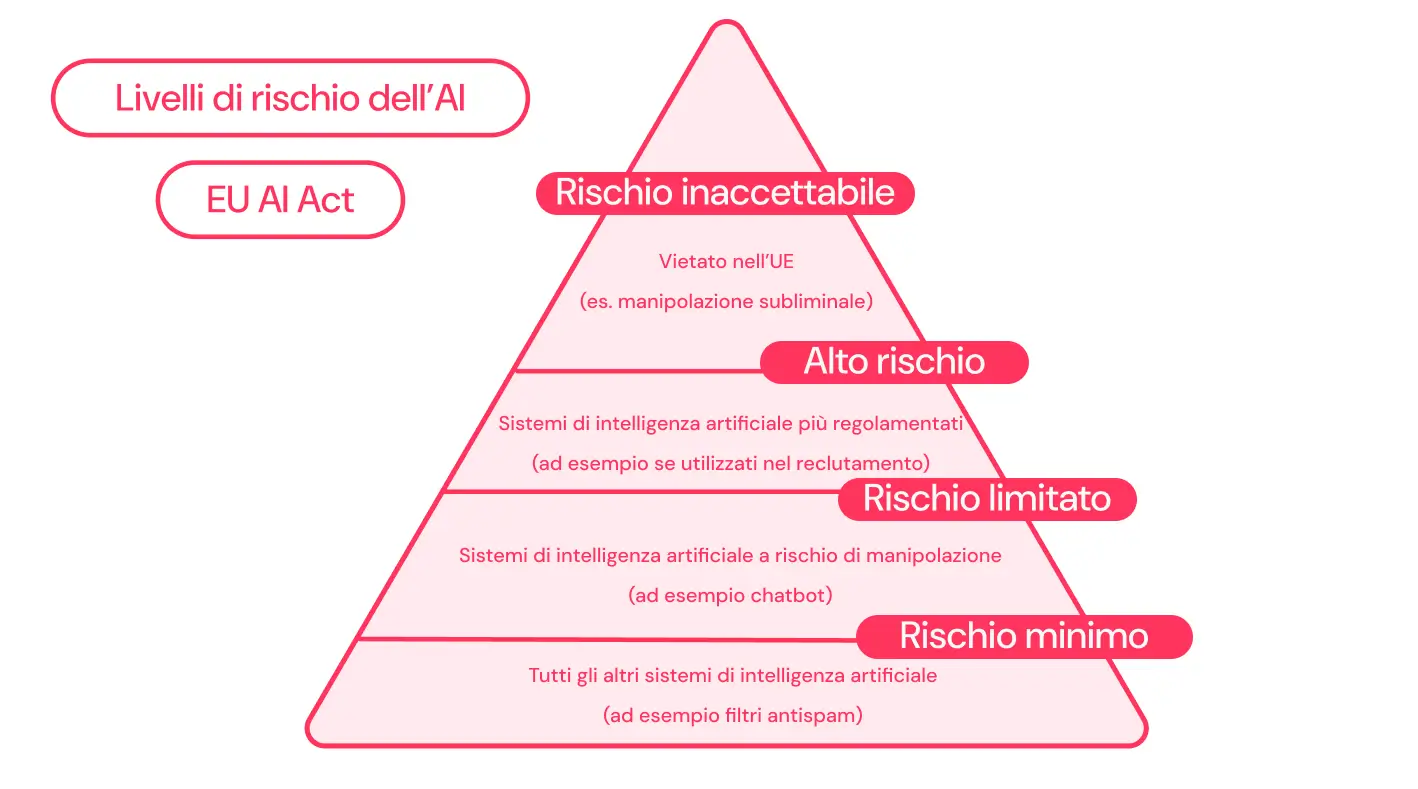

- I livelli di rischio AI Act classificano i sistemi in base al loro potenziale impatto su persone e società.

- Tutte le applicazioni AI dovranno essere tracciabili, trasparenti e progettate per prevenire la creazione di contenuti illegali o discriminatori.

- I datori di lavoro in Italia o in paesi extra UE che collaborano con dipendenti o clienti europei dovranno adeguarsi per rispettare i requisiti di conformità dell’AI Act.

L'integrazione dell'EU AI Act nel quadro normativo italiano

Con l’entrata in vigore della Legge Italiana sull’Intelligenza Artificiale il 10 ottobre 2025, le imprese italiane devono adeguarsi a un quadro normativo nazionale che integra e completa il regolamento l’AI Act dell’Unione Europea (EU AI Act). La legge italiana sull’AI si allinea ai principi fondamentali del regolamento AI Act UE (trasparenza, sicurezza, responsabilità e tutela dei diritti), ma aggiunge regole specifiche per settori chiave come lavoro, sanità, ricerca scientifica, protezione dei minori e diritto d’autore.

In particolare, i datori di lavoro sono tenuti a informare i dipendenti sull’utilizzo di strumenti di intelligenza artificiale e a garantire un’adeguata formazione sull’uso responsabile dell’AI in azienda. La normativa italiana stabilisce anche limiti precisi per l’accesso dei minori: sotto i 14 anni serve il consenso dei genitori, mentre dai 14 ai 18 anni può essere espresso direttamente dai ragazzi, purché le informazioni siano fornite in modo chiaro e comprensibile.

Per quanto riguarda i rischi legali, la legge italiana sull’intelligenza artificiale prevede sanzioni e pene detentive da uno a cinque anni per chi diffonde contenuti manipolati o dannosi generati da AI, oltre a sanzioni più severe per frodi, furti d’identità o altri usi illeciti della tecnologia. In ambito copyright, le opere create con l’ausilio di sistemi AI sono protette solo se frutto di un reale contributo umano, mentre il text e data mining è consentito per scopi di ricerca scientifica approvata.

Due autorità italiane, l’Agenzia per l’Italia Digitale (AgID) e l’Agenzia per la Cybersicurezza Nazionale (ACN), sono incaricate di vigilare sull’attuazione della normativa nazionale, coordinandosi con i principi e i meccanismi di controllo previsti dal regolamento AI Act europeo.

Per le aziende italiane, comprendere e applicare l’EU AI Act significa rispettare le regole europee, evitare sanzioni e promuovere un’adozione dell’intelligenza artificiale sicura, etica e trasparente, coerente con il quadro legislativo nazionale e quello dell’Unione Europea.

Cos'è l'EU AI Act

L’AI Act dell’Unione Europea stabilisce un insieme di regole comuni che tutti gli Stati membri devono adottare per regolamentare l’uso dell’intelligenza artificiale. L’obiettivo è proteggere i diritti fondamentali delle persone, promuovendo allo stesso tempo l’innovazione e la ricerca scientifica. In questo modo, l’Europa punta a creare un quadro normativo che renda l’uso dell’AI più sicuro, trasparente e affidabile.

La legge si basa su un approccio proporzionato al rischio: i sistemi di intelligenza artificiale vengono regolati con diversi livelli di severità a seconda del potenziale impatto che possono avere sugli utenti e sulla società.

Chi sarà interessato dall’EU AI Act

L’AI Act introduce una serie di obblighi per le aziende e gli attori che sviluppano, distribuiscono o utilizzano sistemi di intelligenza artificiale. L’articolo 3 del regolamento definisce chiaramente a chi si applica la normativa:

- Fornitori (provider): persone fisiche o giuridiche, enti pubblici o privati che sviluppano o commissionano lo sviluppo di un sistema o modello di AI a uso generale e lo immettono sul mercato o lo mettono in servizio con il proprio nome o marchio, a titolo gratuito o oneroso.

- Operatori: soggetti che utilizzano un sistema di AI sotto la propria responsabilità in un contesto professionale o aziendale.

- Rappresentanti autorizzati: soggetti incaricati per iscritto dal fornitore di adempiere ad alcuni obblighi previsti dal regolamento per suo conto.

- Importatori: persone fisiche o giuridiche con sede nell’UE che immettono sul mercato europeo un sistema di AI sviluppato da un’azienda con sede fuori dall’UE.

- Distributori: soggetti che fanno parte della catena di fornitura e che collocano sul mercato un sistema di AI, diversi dai fornitori o importatori.

L’idea alla base del regolamento è che i sistemi di intelligenza artificiale possono rappresentare un rischio per i diritti fondamentali. Per questo motivo, l’AI Act classifica i sistemi in base al livello di rischio che comportano: più alto è il rischio, più rigorosi saranno gli obblighi relativi a trasparenza, documentazione e supervisione.

Sintesi dell’EU AI Act

Ecco i punti principali dell’EU AI Act:

Classificazione dei sistemi AI basata sul rischio

L’Unione Europea classifica i sistemi di intelligenza artificiale in base al rischio che comportano per le persone e la società. Più alto è il rischio, più severe saranno le regole su trasparenza, sicurezza e monitoraggio.

Applicazioni a rischio inaccettabile

Alcune applicazioni che manipolano o discriminano le persone sono vietate. Esempi:

- Giocattoli controllati dalla voce che incoraggiano comportamenti pericolosi nei bambini

- Sistemi di punteggio sociale che classificano le persone in base a caratteristiche come comportamento sociale o status socioeconomico

- Identificazione biometrica remota in tempo reale in spazi pubblici, come il riconoscimento facciale

Secondo l’EU AI Act, queste applicazioni rappresentano un rischio inaccettabile per le persone e per la società.

Sistemi AI ad alto rischio

I sistemi AI che comportano un rischio molto elevato sono consentiti solo a determinate condizioni, come test, monitoraggio e certificazione.

Sono suddivisi in due categorie principali:

- Sistemi AI integrati nei prodotti (ad esempio dispositivi medici, veicoli, giocattoli)

- Sistemi AI in settori critici della società (ad esempio infrastrutture critiche, istruzione, forze dell’ordine)

Tutti i sistemi AI ad alto rischio saranno valutati durante tutto il ciclo di vita. Inoltre, i cittadini UE potranno presentare reclami relativi a questi sistemi.

Altre classi di rischio

- Rischio limitato: ad esempio un chatbot che fornisce informazioni generali sui prodotti. Non riguarda la sicurezza, ma gli utenti devono sapere che le risposte sono generate dall’AI.

- Rischio minimo: ad esempio un’applicazione AI per il controllo ortografico e grammaticale. Supporta l’utente ma non comporta rischi significativi per salute, sicurezza o diritti fondamentali.

Requisiti di trasparenza

Tutti i sistemi e le applicazioni AI devono rispettare requisiti di trasparenza. Ad esempio, i modelli generativi come ChatGPT non sono considerati ad alto rischio, ma devono comunque rispettare:

- Dichiarazione chiara: indicare che il contenuto è stato creato con l’AI

- Evitare contenuti illegali: i modelli devono essere progettati per non generare contenuti illeciti

- Copyright: quando si usano dati di addestramento, bisogna creare e rendere disponibili sommari dei contenuti protetti da copyright

Le autorità nazionali dovrebbero anche fornire ambienti di test controllati, dove i modelli AI possono essere provati prima della diffusione su larga scala.

Impatto della regolamentazione AI per i datori di lavoro

Come accennato, l’EU AI Act impone regole alle aziende che sviluppano, operano o distribuiscono applicazioni AI all’interno dell’UE. Per le aziende, questo significa:

- Valutazione del rischio: bisogna identificare in quale categoria di rischio rientrano i propri sistemi AI (rischio inaccettabile, alto rischio, rischio limitato, rischio minimo). Questo vale per tutti gli operatori di modelli AI.

- Obblighi di conformità: a seconda della categoria di rischio, vanno rispettati requisiti come trasparenza, documentazione tecnica, certificazione e segnalazione di incidenti gravi. Gli operatori di sistemi AI a rischio limitato, ad esempio, devono solo indicare che si tratta di sistemi AI.

- Obbligo di formazione AI: i dipendenti devono essere formati sull’uso sicuro e conforme alla legge dell’AI, in linea con l’AI Literacy. Tuttavia, questo obbligo riguarda principalmente gli operatori di sistemi ad alto rischio.

- Monitoraggio e documentazione: i sistemi AI ad alto rischio devono essere monitorati, documentati e valutati durante tutto il loro ciclo di vita.

Cosa devono considerare i responsabili HR

L’impatto dell’AI sui team HR è significativo, soprattutto per team piccoli o composti da una sola persona. Strumenti AI utilizzati nei processi di reclutamento hanno già permesso di risparmiare tempo e denaro, ad esempio nella creazione di job description, centralizzazione delle informazioni sui candidati e selezione dei CV.

Entro il 2027, tali sistemi dovranno rispettare le normative sull’AI. I team HR dovranno verificare che i software di recruitment AI siano conformi ai requisiti di trasparenza. Inoltre, tutte le tecnologie HR e gli strumenti digitali avanzati utilizzati nell’UE dovranno dimostrare di essere equi, trasparenti e sicuri.

Infine, i responsabili HR dovranno preparare il proprio team alla formazione sull’AI, per proteggere gli utenti da minacce o contenuti dannosi generati dall’AI.

Perché i CEO devono prestare attenzione

I leader aziendali e i CEO dovranno trovare un equilibrio tra innovazione e conformità. Tutti i sistemi AI utilizzati, creati o distribuiti nell’UE dovranno rispettare queste nuove regole entro il 2027.

È fondamentale restare informati e comunicare eventuali cambiamenti, adattando i processi per evitare sanzioni costose. I leader proattivi che implementano politiche per garantire la conformità preparano la loro azienda al successo a lungo termine.

Anche se la tua azienda non opera direttamente nell’UE, CEO e leader devono agire subito, poiché ulteriori regolamentazioni sull’AI a livello globale sono inevitabili.

Costi di conformità per i team Finance

I team Finance devono essere consapevoli dei rischi economici legati alla non conformità con l’EU AI Act. Conoscere le normative AI permette di:

- Pianificare budget per audit e programmi di conformità

- Formare il personale in modo adeguato

Un’attenta preparazione aiuta a ridurre il rischio di sanzioni finanziarie.

Se sei un responsabile finanziario, inizia a lavorare con i team HR e legali per pianificare strategie volte a mitigare il rischio economico.

Come l'AI di Factorial supporta la conformità

Oggi molte aziende utilizzano diverse applicazioni AI nelle loro attività quotidiane. La responsabilità della conformità alle normative non ricade sulle aziende, ma sui fornitori dei sistemi AI.

Con l’AI di Factorial, le aziende hanno a disposizione una soluzione che comprende davvero la loro struttura, i team e gli obiettivi. Invece di perdere tempo con processi manuali, le attività possono essere completate fino a tre volte più velocemente. Il risultato? Insight chiari e basati sui dati che favoriscono la crescita. Questo permette di aumentare l’impatto, riducendo al contempo i costi – un vero supporto nel lavoro quotidiano.

Esempi pratici di utilizzo:

- Performance management: trascrizione live degli incontri 1:1, recap strutturati con contesto (pulse signals, note precedenti, variazioni dei KPI) e creazione automatica di un piano d’azione modificabile

- Recruiting / ATS: sfrutta l’AI per scrivere job description, selezionare i migliori candidati, generare riassunti dei CV e accelerare il processo di reclutamento

- Rota / gestione turni: pianificazione automatica dei turni supportata dall’AI, con creazione e pubblicazione rapida dei programmi per tutto il team

- Finanza: scansione mobile delle ricevute, acquisizione dati con OCR AI, assegnazione automatica a policy e centri di costo, promemoria per invii puntuali, per avere un controllo più stretto delle spese

- Analytics / Report: risposte istantanee dai dati in tempo reale, report automatici, analisi precise senza Excel o analisti

Factorial è il software gestionale aziendale All-in-one con AI integrata, grazie al quale i team possono beneficiare dei vantaggi dell’AI senza correre rischi legali, avendo la certezza che tutte le funzionalità siano implementate nel rispetto delle normative UE e italiane.

👉 Chiedi una demo gratuita e scopri tutte le funzionalità e i vantaggi che un software come Factorial può portare alla tua azienda.

Domande sull’EU AI Act

Perché le aziende italiane dovrebbero preoccuparsi della legislazione europea?

L’EU AI Act si applica a tutte le aziende che sviluppano, distribuiscono o utilizzano sistemi AI all’interno dell’UE. Se la tua azienda ha sedi in altri paesi UE, dipendenti residenti nell’UE, o utilizza sistemi AI che impattano cittadini/residenti UE, allora la normativa ti riguarda.

Non usiamo sistemi AI, dobbiamo preoccuparci lo stesso?

Sì. L’EU AI Act regolamenta tutti i sistemi AI, inclusi modelli generali come ChatGPT o Copilot. Anche se l’uso di AI non è centrale per la tua azienda, è consigliato verificare quali strumenti vengono utilizzati internamente o dai fornitori, perché potresti comunque essere coinvolto.

L’EU AI Act si applica direttamente in Italia?

L’atto europeo entra in vigore in tutti i Paesi membri dell’UE, Italia compresa. Tutte le aziende che operano sul territorio UE dovranno rispettare le regole quando utilizzano, sviluppano o distribuiscono sistemi AI ad alto rischio o generali. Le sanzioni sono previste per chi non rispetta i requisiti di trasparenza, sicurezza e monitoraggio.

Quando è stato approvato l’EU AI Act?

L’EU AI Act è stato adottato ufficialmente nel 2024. La normativa sarà applicata gradualmente e diventerà pienamente vincolante entro il 2027.

Le ultime tendenze in gestione, leadership e coinvolgimento dei team.

Iscrizione confermata!

D'ora in poi riceverai le ultime novità direttamente nella tua casella di posta!

Qualcosa è andato storto. Riprova.